Hiểu sai gợi ý của ChatGPT, người đàn ông suýt mất mạng

Một người đàn ông Mỹ vì muốn giảm muối đã uống nhầm bromua natri suốt 3 tháng, dẫn đến ngộ độc hiếm gặp và phải nhập viện khoa tâm thần điều trị. Vụ việc gây chấn động giới y khoa.

Ngày 18/8, truyền thông Mỹ đưa tin một người đàn ông 60 tuổi vì muốn giảm muối, đã hiểu nhầm gợi ý của ChatGPT, liên tục trong 3 tháng dùng bromua natri (sodium bromide), dẫn đến mắc phải chứng ngộ độc brom hiếm gặp. Cuối cùng ông bị đưa vào bệnh viện tâm thần và phải nhập viện suốt 3 tuần.

Theo trang The Guardian, trường hợp này đã được công bố trong số đầu tháng 8 của tạp chí Annals of Internal Medicine, do 3 bác sĩ thuộc Đại học Washington đồng tác giả.

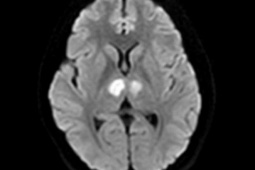

Theo đó, một người đàn ông 60 tuổi không có bất kỳ tiền sử bệnh tâm thần nào, khi nhập viện đã khẳng định hàng xóm có thể đang đầu độc mình, và tỏ ra nghi ngờ đối với nguồn nước uống mà bệnh viện cung cấp. Ông khăng khăng chỉ uống nước do chính mình chưng cất tại nhà, đồng thời có các triệu chứng hoang tưởng và ảo giác.

Ảnh minh họa.

Sau khi bác sĩ tiến hành thăm khám thêm, họ phát hiện người đàn ông này có nhiều vấn đề trong chế độ ăn uống. Mặc dù đã rõ ràng bị mất nước nhưng ông vẫn không chịu uống nước, hơn nữa còn bị kích động mạnh, nói năng không rõ ràng.

Không chỉ vậy, người đàn ông thậm chí trong vòng 24 giờ sau khi nhập viện đã tìm cách bỏ trốn, cuối cùng vì tình trạng nghiêm trọng nên bị buộc phải đưa đến khoa tâm thần để theo dõi điều trị.

Mãi đến khi tình trạng của ông ổn định, ông mới thừa nhận với bác sĩ rằng sau khi tra cứu những ảnh hưởng tiêu cực của muối ăn (natri clorua, sodium chloride) đối với sức khỏe, ông đã thử tiến hành một “thí nghiệm giảm muối”, thậm chí còn đặc biệt hỏi ChatGPT về phương án thay thế.

Kết quả, sau khi ông nhìn thấy ChatGPT trả lời rằng “muối ăn có thể được thay thế bằng bromua (thường dùng trong tẩy rửa)” thì lại hiểu sai thành có thể ăn được, rồi tiếp tục tự mình sử dụng bromua natri liên tục suốt 3 tháng.

Mặc dù các bác sĩ không thể lấy được bản ghi đầy đủ cuộc trò chuyện giữa người đàn ông và ChatGPT, nhưng khi họ tự dùng ChatGPT 3.5 để hỏi câu “muối ăn có thể được thay thế bằng gì” thì cũng nhận được câu trả lời tương tự là bromua, mà không hề kèm theo cảnh báo rõ ràng về rủi ro sức khỏe, cũng không có giải thích cụ thể về mục đích sử dụng.

Báo cáo chỉ ra rằng: “Điều này hoàn toàn đi ngược lại với cách làm mà chúng tôi cho rằng các chuyên gia y tế nên có”.

Theo báo cáo, ngộ độc brom (bromism) từng khá phổ biến vào đầu thế kỷ 20, bởi khi đó nhiều loại thuốc không kê đơn và thuốc an thần đều chứa thành phần brom. Ước tính khi ấy, gần 10% số ca nhập viện tâm thần có liên quan đến tình trạng này.

Mặc dù hiện nay căn bệnh này cực kỳ hiếm gặp, nhưng vì “việc mua các sản phẩm chứa bromua trên mạng ngày càng dễ dàng”, nên những năm gần đây các ca bệnh tương tự lại bắt đầu xuất hiện.

Thư viện Y học Quốc gia Mỹ cũng chỉ ra rằng, bromua hiện nay chỉ được dùng làm thuốc chống co giật cho mèo và chó, hoàn toàn không phù hợp cho con người sử dụng như thực phẩm.

Ca ngộ độc đầu tiên do AI gây ra được ghi nhận, cẩn trọng những lời khuyên chết người từ ChatGPT.

Nguồn: [Link nguồn]

-23/08/2025 08:52 AM (GMT+7)